Marian - Nie 02 Gru, 2007 Temat postu: Optymalne rozmiary obrazu Niestety dopiero niedawno spostrzegłem, że optymalny rozmiar obrazu w aparacie z filtrem Bayera, to obraz o czterokrotnie mniejszej ilości pikseli od maksymalnej, udostępnianej przez producenta. Przykładowo w mojej lustrzance optymalny rozmiar to 1000×1504, a nie maksymalny podawany przez producenta, czyli 2000×3008. W gruncie rzeczy jeśli się przez chwilę zastanowić, to nawet nie ma w tym nic dziwnego. Szkoda tylko, że tak długo bezmyślnie i niepotrzebnie ulegało się pogoni za maksymalną liczbą pikseli, ustawiając maksymalny rozmiar zaoferowany przez producenta. Czy ktoś z Was też to zauważył i takiego dwukrotnie mniejszego x i y używa, jako podstawowego ustawienia? maziek - Nie 02 Gru, 2007 Dlaczego? Marian - Nie 02 Gru, 2007

Spróbuj porównać oba takie obrazy przy 100 procentowym widoku (ja oglądam na monitorze o rozdzielczości 96 pikseli), a zobaczysz że ten większy jest "rozmazany, nieostry" i zmienia się na normalny jak jego widok ustawisz na 50 procent. Z kolei nie ma takiego "rozmazania" przy 100 procentowym widoku, gdy oglądasz obraz z Sigmy SD-14 nie stosującej filtru Bayera, a także gdy zmniejszysz maksymalne dostępne w aparacie rozmiary obrazu x i y o połowę, jeśli ten aparat używa filtru Bayera. Arv - Nie 02 Gru, 2007

Nie zgadzam się w całej rozciągłości. Tak się składa, że oko dużo bardziej szczegółowo rozróżnia jasność od koloru. Fakt ten jest powszechnie wykorzystywany w rozmaitych aplikacjach (telewizory, kompresja jpeg/mpeg, DVD, matryca Bayera). Dzięki temu aparaty wyposażone w matrycę Bayera osiągają porównywalny (lub lepszy) efekt za ułamek ceny aparatów wyposażonych w matrycę Forveon. Pozatym, kto ogląda zdjęcia w cropie 100% ? Arv - Nie 02 Gru, 2007 Marian - Ty to naprawdę masz jakieś halo na punkcie aparatów Sigmy. Przejrzyj swoje posty: http://forum.optyczne.pl/...h_author=Marian Już raz Cię podejrzewałem o zawoalowany marketing. Marian - Nie 02 Gru, 2007

Jeśli obraz nie jest "rozmazany", to dlaczego oglądać go z mniejszą ilością szczegółów od tej jaka jest w nim zawarta? Gdy zauważyłem że wybieram niepotrzebnie maksymalne rozmiary obrazu, ponownie zajrzałem do obrazów z Sigmy, i tam rozmazania nie widać nawet przy widoku 100%. Zajrzyj sam, a polubisz oglądanie wszystkich szczegółów zdjęcia, czyli 100% widok. Ponownie zapewniam że nie mam nic wspólnego z Sigmą. MM - Nie 02 Gru, 2007 Popatrzcie sobie na dobry kadr 1:1 z Canona 5D i możecie nie poznać, że to crop. Tyle o Sigmach i innych bajerach. maziek - Nie 02 Gru, 2007 Wg mnie Marian to tez nie masz racji ale postanowiłem to organoleptycznie sprawdzić, zanim tak do końca to wypowiem. Weź jednak pod uwagę, że gdy dla uproszczenia rozpatrywać zdjęcie bw, to ponieważ aparat wie który pixel jakim filtrem jest zasłonięty, to dokonując zwykłego odejmowania jest w stanie stwierdzić jego rzeczywista jasność. Tak więc bez wątpienia w bw masz taką rozdzielczość, ile pixeli. Czy coś się zmienia po dodaniu kolorów? Nic. Ewentualnie mozna mieć zastrzeżenia, że kolory są wydumane a nie prawdziwe (aparat je wydumał). Ale nawet jeśli, to nie ma to żadnego wpływu na rozdzielczość. Arek - Nie 02 Gru, 2007 Nie zgodzę się z Marianem. Takie wrażenie można odnieść operując na plikach JPG i to wyostrzonych, gdzie dzieją się cuda. Rzućcie okiem na poniższy rysunek:

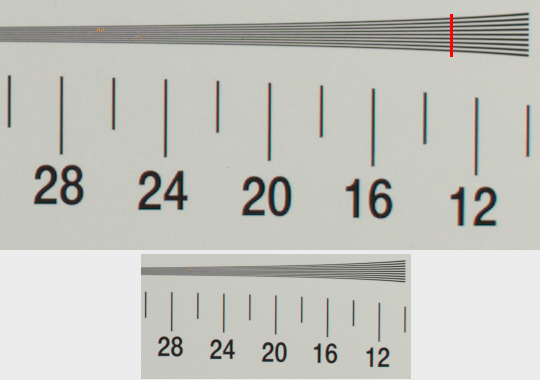

Górna część to wycinek 1:1 ze zdjęcia naszej tablicy wykonanego zestawem D200 plus Sigma 1.4/30 ustawiona na f/5.6. Oczywiście RAW wołany do TIFFa bez wyostrzenia i potem zapisany bezstratnie do PNG. Poniżej ta sama sytuacja przy skalowaniu 2:1. Ja nie mam wątpliwości gdzie widać więcej. Dodatkowo narysowałem pionową czerwoną kreskę, żeby pokazać jeszcze jedną rzecz. Otóż wiele osób krytykując różnego rodzaju testy powołuje się na twierdzenie Shannona (http://pl.wikipedia.org/wiki/Twierdzenie_Kotielnikowa-Shannona ) mówiące o tym, że sygnał ciągły może być ponownie odtworzony z sygnału dyskretnego, jeśli był próbkowany z częstotliwością co najmniej dwa razy większą od granicznej częstotliwości swego widma (tzw. częstotliwości Nyqyista). Bezpośrednie zastosowanie tego twierdzenia do danych z aparatów cyfrowych, mówi nam, że na zdjęciach np. z D200 nie powinniśmy zobaczyć niczego poniżej 1300 LWPH. Poziom ten oznaczyłem pionową czerwoną kreską. Bezpośrednie i bezmyślne zastosowanie tego twierdzenia oznacza, że wszystko po lewej stronie czerwonej kreski to szum i wymysły programistów Nikona. Rzut okiem na poniższy wycinek pokazuje, że tak łatwo nie ma. Postaram się napisać jakiś artykuł na ten temat, bo zbyt dużo nieporozumień z tego wynika. Marian - Nie 02 Gru, 2007

Mnie nie chodziło o porównywanie przeskalowanego zdjęcia, tu mniej szczegółów nie musi być czymś zaskakującym, ale o zrobienie zdjęcia z o połowę mniejszymi x i y. I czy takie zdjęcie będzie miało mniej szczegółów od tego z maksymalnymi rozmiarami? Może masz takie zdjęcie? Poza tym testowa tablica ma zbyt łatwy dla algorytmów interpolacyjnych rysunek. Arek - Nie 02 Gru, 2007 A czym to się różni? Przecież aparat robi zdjęcia zawsze tą samą matrycą, a potem zapisuje w zadanym rozmiarze używając innej elementarnej komórki. Marian - Nie 02 Gru, 2007

Jeśli zaś z tych fotodiod musi stworzyć cztery piksele a nie jeden, wyniki będą różne. maziek - Nie 02 Gru, 2007 Ale to nie ma związku z rozdzielczością. Arv - Nie 02 Gru, 2007 Marian - albo nie rozumiesz, albo nie chcesz zrozumieć, że interpolacja koloru nie jest niczym złym. Przeciwnie jest DOBRODZIEJSTWEM dzięki, któremu mamy tańsze matryce o doskonałej jakości. Pozatym to niekoniecznie jest tak, że kolory pikseli w kwadracie 4x4 są interpolowane. Weżmy przykładowy schemat:

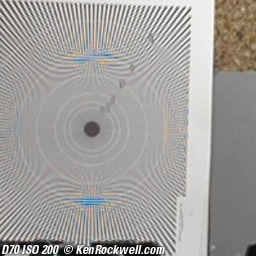

Spróbuj sobie wyobrazić, że piksele wynikowe nie są tam gdzie literki tylko tam gdzie plusiki !!! Każdy plusik ma jasność i kolor wyliczony z najbliższych mu sensorów - czerwonego, niebieskiego i dwu zielonych. Strata z interpolacji polega tylko na tym, że wynikowy piksel (plusik) ma dwa sensory wspólne z każdym swoim sąsiadem. Dlaczego 'tylko' ? O tym za chwilę. W każdym urządzeniu cyfrowym musi istnieć filtr antyaliasingowy. Filtr ten w aparatach cyfrowych powoduje że na zdjęciu nie rejestrują się detale, których rozdzielczość jest większa niż rozdzielczość matrycy/2. Dlaczego ? Bo zarejestrowanie ich skutkuje powstaniem moiry. (To konsekwencja twierdzenia Shannona-Kotielnikowa). Moira wygląda np. tak:

Jeżeli filtr AA oraz algorytmy antyaliasingowe i demozaikujące są zaimplementowane poprawnie to SZCZEGÓŁY OBRAZU mniejsze niż dwa piksele NIE BĘDĄ WIDOCZNE na zdjęciu !!!! W przeciwnym wypadku MUSI pojawić się moira (na marynarkach w prążki, na firankach, na ogrodzeniu, na cegłach itp.) A skoro filtr AA i tak usuwa większość detali mniejszych niż dwa piksele to fakt, że sąsiadujące piksele mają wspólne sensory nie jest już taką stratą jak wydawało się na początku prawda ? Sigma również musi mieć filtry i algorytmy AntiAliasingowe albo obrzymią moirę i schodkowanie krawędzi. Jedno i drugie powoduje, że matryca Sigmy o tej samej liczbie pikseli co matryca Bayerowska NIE OSIĄGNIE DWUKROTNIE WIĘKSZEJ ROZDZIELCZOŚCI* !!! Osiągnie natomiast trzykrotnie większą cenę (bo ma trzy razy więcej sensorów na piksel). Dlatego ten wynalazek mimo naprawdę wielu zalet po prostu się nie przyjmie dopóki cena matrycy ma wpływ na cenę aparatu. Uprzedzając protesty tych, którzy nie zgadzają się z tym, że filtr AA powinien działać tak jak napisałem ... Popatrzcie na dowolne testy rozdzielczości. Co dzieje się z grubością zanikających linii po przekroczeniu progu częstotliwośći nyquista ? Wiecie jak się nazywa to zjawisko ? ALIASING. Dobranoc. --- * - rozdzielczości w sensie jednowymiarowym mierzonej np. w LWPH. Marian - Pon 03 Gru, 2007

Czy chcesz powiedzieć, że dzięki temu obraz zawiera więcej informacji od obrazu, w którym każdy piksel tworzą cztery oddzielne (RGGB) fotodiody, nie pokrywające się ?

Tu się mylisz. Filtr AA nie jest konieczny jeśli rozdzielczość matrycy jest większa od rozdzielczości obiektywu.

No to po co w takim razie "nadymać" obraz wspólnymi sensorami?

Arv - Pon 03 Gru, 2007

Skądże. Chcę powiedzieć, ze wbrew pozorom obraz z matrycy bayera zawiera tyle samo UŻYTECZNEJ informacji co obraz z matrycy foveon. Cała reszta leży powyżej częstotliwości nyquista więc zamiast informacji użytecznej zawiera MOIRĘ, ALIASING i SCHODKOWANIE (w zasadzie to synonimy są)

Nieprawda. Nie chce mi się tego udawadniać dla własnej satysfakcji a mam wrażenie że Ciebie i tak nie przekonam. Na pocieszenie powiem, że rozdzielczość obiektywów będzie jeszcze długo większa niż matryc. Pozatym po co konstruować matrycę, której rodzielczości nie da się wykorzystać ? Pozatym filtr AA wcale nie jest konieczny. Ale jak z niego zrezygnujesz masz gwarantowany aliasing. Co prawda aliasing w forveonie jest przyjemniejszy niż w bayerze bo nie pojawiają się barwne artefakty. Ale aliasing jest aliasingiem i kropka.

Dlaczego uważasz że wspólne sensory cokolwiek nadymają ? A są wspólne bo tak jest taniej.

Przykro mi, że mój post nie został dokładnie przeczytany. Matryca ma monochromatyczne sensory o kolorach R G B. Tych G jest dwa razy więcej. Piksel obrazu wynikowego tworzony jest na podstawie informacji z czerech sensorów. Każde dwa sąsiadujące piksele mają po dwa sensory wspólne. komor - Pon 03 Gru, 2007

Czy aby na pewno? Może ja źle rozumuję, ale z testów na Optycznych wywnioskowałem coś dokładnie odwrotnego. Najlepsze obiektywy osiągały najwyższą teoretyczną rozdzielczość wynikającą z parametrów matrycy, a te słabsze - nie. Czy źle zrozumiałem? Poza tym ktoś wspominał tu też o krążku rozproszenia, który obecnie pokrywa więcej niż jeden piksel matrycy. Arv - Pon 03 Gru, 2007

Zwróć uwagę ile jest takich obiektywów w testach, których wykres dobiega w najwyższym punkcie do maksimum rozdzielczości matrycy. Założę się, że więcej niż 75%. Pozatym teraz mamy modę na Full Frame. Upłynie duuuużo wody w Wiśle zanim upakowanie pikseli na 35 mm sięgnie gęstości pikseli w matrycy Olympusa ;-). Marian - Pon 03 Gru, 2007

ad.1 Niepotrzebnie wydaje mi się przenosisz rozważania na matrycę Foveon i Sigmę. Dajmy im spokój. Interesuje mnie coś bardziej ogólnego. To co mnie interesuje to nie Sigma czy Foveon, tylko jakie rozmiary obrazu wybrać w ustawieniach aparatu przed zrobieniem zdjęcia. I tutaj dochodzę do wniosku że jeśli w aparacie mam filtr Bayera, to optymalnie będzie wybrać takie rozmiary, które odpowiadają połowie podawanych przez producenta poziomych i pionowych ilości pikseli (a właściwie fotodiod) matrycy. Dlaczego? Bo ilość użytecznej informacji jest taka jak dla obrazu o maksymalnych wymiarach. ad.2 Nie należę do ludzi, którzy nie zmieniają zdania, jeśli okaże się że się mylę. Im dłużej rozdzielczość matryc będzie mniejsza od rozdzielczości obiektywów, tym dłużej będę używał filmów, a nie matryc. Po co matryce o większej rozdzielczości? Wykorzysta się je np. do wyeliminowania mory i ostrzejszych zdjęć dzięki rezygnacji z filtru AA. ad.3 "Nadymanie" czyli powiększanie liczby pikseli które nie zwiększają w obrazie ilości użytecznej informacji. benetnash - Pon 03 Gru, 2007 Mam tylko jedno pytanie: jeżeli wg. Ciebie niektóre piksele są interpolowane na podstawie innych, dlaczego na najwyższych czułościach widać szum o jednopikselowym ziarnie? Marian - Pon 03 Gru, 2007

Arv - Pon 03 Gru, 2007

Niestety nie. Aby zapisać cyfrowo użyteczną informację bez przekłamywania jej - trzeba (w uproszczeniu) podwoić liczbę próbek. Dlatego aby płytka CD przenosiła dźwięk o częstotliwości 22kHz, częstotliwość próbkowania wynosi 44kHz. Jak zmniejszysz częstotliwość próbkowania do 22kHz to najwyższy dźwięk jaki będzie można prawidłowo zapisać będzie miał częstotliwość 11kHz. Talerze perkusji nie będą już brzmiały tak samo. To samo jest w fotografii cyfrowej. Zdjęcie z każdej matrycy faktycznie przenosi prawidłowo detale o rozmiarze dwu pikseli. Ale jak je zmniejszysz o połowę (wysokość i szerokość) to utracisz kolejne detale (co empirycznie pokazał wyżej Arek). Znalazłem przypadkiem lepszy przykład jak to może wyglądać na obrazie:

Chociaż tutaj zmniejszenie jest bardziej radykalne. http://en.wikipedia.org/w...n_of_bricks.jpg http://en.wikipedia.org/w...ricks_small.jpg Marian - Wto 04 Gru, 2007

Przykład który podajesz ilustruje coś zupełnie innego od tego o czym ja piszę. Ilustruje niepoprawny downsampling. Cytat ze strony z przykładem: "A brick wall demonstrating a Moiré pattern when badly downsampled." Przecież ja nie piszę o downsamplingu. maziek - Wto 04 Gru, 2007 Może Optyczni zrobią test Sigmy i wiele się wyjaśni... Arv - Wto 04 Gru, 2007

Jak to nie ? Piszesz o zmniejszeniu rozdzielczości. Przecież to downsampling. Może nie "bad downsampling" ale zawsze ... ;-) Marian - Wto 04 Gru, 2007

W takim razie spróbuję to wyjaśnić inaczej. Oznaczmy przez x ilość fotodiod matrycy poziomo, a przez y ilość fotodiod matrycy pionowo, w matrycach z filtrem Bayera. x*y to zatem zwykle rozmiar podawany jako rozmiar matrycy (pisze się zwykle że jest wyrażony w pikselach), i zwykle jest to największy możliwy do wybrania w ustawieniach aparatu rozmiar obrazu w pikselach. Przyjmijmy że mówimy o matrycach kolorowych i że przez piksel rozumiemy obiekt dostarczający informacji o trzech kolorach R (czerwonym) G (zielonym) i B (niebieskim). Matryca z filtrem Bayera dostarcza użytecznej informacji o x/2*y/2 trójkolorowych pikseli typu RGGB, czyli o x*y/4 trójkolorowych pikseli RGGB. Jeśli wybierasz w ustawieniach aparatu rozmiar obrazu x*y to algorytmy aparatu robią z tych x*y/4 pikseli RGGB cztery razy więcej pikseli RGB, czyli czterokrotnie powiększają liczbę trójkolorowych pikseli. Zatem mamy do czynienia z przeciwieństwem downsamplingu, nazwijmy to upsamplingiem (powiększaniem ilości pikseli). Problem o którym piszę, to zatem robienie przez aparat, gdy wybierzemy rozmiary x*y w ustawieniach aparatu, na podstawie tej samej ilości informacji, z tej samej ilości fotodiod, czterokrotnie większej ilości trójkolorowych pikseli. Zatem nie ja robię downsampling, tylko aparat robi upsampling. Mam nadzieję, że teraz już jest jasne, że ja nie robię żadnego downsamplingu wybierając w ustawieniach aparatu dostępny tam rozmiar obrazu x/2*y/2 maziek - Wto 04 Gru, 2007 Tylko pytanie, czy aparat sie tym przejmuje, że nastawisz dwa razy mniejszą rozdzielczość. Bo może jak napisał Arek odczyt z matrycy jest pełny, a soft dopiero dokonuje zmniejszenia... Arek - Wto 04 Gru, 2007 I to zapisując w JPG, bo tylko niektóre aparaty mają sRAW. Arv - Wto 04 Gru, 2007

W tym miejscu Twoje rozumowanie jest błędne. Matryce nie działają tak, że informacja z czterech sensorów tworzy tylko jeden piksel. W ten sposób tracilibyśmy wiele cennej informacji która związana jest z rozmieszczeniem poszczególnych sensorów. Wykonaj na sobie prosty eksperyment medyczny ;-) Trzymając nieruchomo głowę i oczy zamknij na chwilę oko lewe - widzisz tylko lewą stronę. Otwórz lewe a zamknij prawe. Widzisz tylko prawą. A teraz otwórz szeroko oczy i zastanów się jakie byłoby marnotrawstwo informacji gdyby mózg brał pod uwagę jedynie to co jest w zasięgu wzroku obu oczu jednocześnie !!! Oprogramowanie tworzące obraz z pliku RAW też nie marnotrawi żadnej informacji. Obraz jaki powstaje w wyniku przetworzenia danych z matrycy ma rozdzielczość odpowiadającą rozdzielczości matrycy. Ponieważ obraz ten ma postać cyfrową podlega tym samym prawom, którym podlegają inne próbkowane materiały cyfrowe takie jak dźwięk, video, obrazy ze skanera czy matrycy w innej technologii. Wszystkich próbkowanych materiałów dotyczy twierdzenie Shanonna-Kotielnikowa. A z twierdzenia tego wynika, że szczegóły obrazu o rozmiarze mniejszym niż dwa piksele są zniekształcone. (Bez względu na sposób powstawania rastrowego cyfrowego obrazu - nawet czterokrotne zmniejszenie rozdzielczości tego nie zmieni.) Ponadto wiadomo, że oko "nie dba" o kolory pojedyńczych punkcików. Kolory pojedyńczych punkcików 'zlewają' się w barwne plamy. Wniosek z tych dwu faktów jest taki, że obraz prawie nic nie traci gdy sąsiednie piksele "pożyczają" sobie informacje o kolorze. Marian - Wto 04 Gru, 2007

Marian - Wto 04 Gru, 2007

Oczywiście karkołome tylko w przypadku ustawienia przez użytkownika rozmiaru x/2×y/2 obrazu. Marian - Wto 04 Gru, 2007

Arv - Wto 04 Gru, 2007

Ja potrafię dostrzec, że tak jest. Choćby po przykładzie Arka w tym wątku. Jeżeli masz wątpliwości, to mam dla Ciebie interesującą lekturę w języku stworzonym przez Richiego i Kernigana (nie przekręciłem nazwisk?) http://www.cybercom.net/%7Edcoffin/dcraw/dcraw.c http://www.cybercom.net/%7Edcoffin/dcraw/ ;-) Prawda jest jeszcze okrutniejsza ;-)))) http://scien.stanford.edu...dep/vargra.html I nie myśl czasem, że w foveonie się niczego nie interpoluje ;-))))

Możesz też przerobić sobie zaimplementowany tam algorytm zgodnie z własnymi pomysłami. Jeżeli będzie lepszy - to jeszcze zarobisz kupę szmalu ;-) Marian - Wto 04 Gru, 2007

Na podstawie tej lektury nadal nie wiemy jakich algorytmów używają producenci do wygenerowania pliku o rozmiarach x/2×y/2 Marian - Wto 04 Gru, 2007

Zmuszony jestem założyć, że pewności nie masz, tylko się domyślasz. Marian - Wto 04 Gru, 2007

Rzeczywiście prawda jest jeszcze okrutniejsza, że takimi metodami kreuje się obrazy mające odzwierciedlać rzeczywistość, że tyle zbytecznej pracy jest wykonywane. Ale dzięki temu można się pochwalić większą ilością pikseli w obrazie, i utwierdzić użytkownika w przekonaniu, że otrzymuje bardziej szczegółowy obraz rzeczywistości, a więc w domyśle wierniejszy niż faktycznie nim jest. W przypadku skomplikowanych obrazów, szczegółowych i niezawierających regularności w rozłożeniu kolorów te algorytmy niewiele dadzą, ponad to co można uzyskać traktując cztery fotodiody RGGB jako jeden piksel. W przypadku prostych obrazów tym bardziej są zbyteczne. Jeśli naszym celem jest jak najwierniejsze oddanie rzeczywistości. Chyba że nie o to chodzi, a o "wypchanie" plików dużą ilością pikseli. Arv - Sro 05 Gru, 2007

Mam. Bo wiem, że nie ma różnicy. Nie wiem czy się orientujesz ale to co rejestruje matryca zapisywane jest w plikach typu RAW. Plik RAW w moim aparacie ma zawsze taką samą rozdzielczość - i jest to rozdzielczość matrycy. To co się dzieje potem (czyli algorytm zmiany RAW w JPG) można robić w aparacie, można na komputerze. Można nawet porównać efekt działania różnych algorytmów. Marian zrób dwa zdjęcia Twoim Nikonem. Jedno w normalnym rozmiarze. Drugie tak jak uważasz - w aparacie. Potem to w normalnym rozmiarze przeskaluj na komputerze tak jak Arek i pokaż różnicę. Tutaj np. znajdziesz ISO test chart: http://www.graphics.corne.../res-chart.html Udowodnisz, że masz rację i utniesz niepotrzebne dyskusje.

Twoja teoria i propozycja nowego algorytmu konwersji RAW jest bardzo interesująca. Chciałbym abyś udowodnił Twoją tezę i pokazał, że Ci wszyscy, którzy opracowywali algorytmy konwersji RAW dbali tylko o marketingowy efekt megapiksela a nie rzeczywistą jakość obrazu. (Co byłoby szczególnie oburzające w przypadku autora opensource'owego dcraw'a). Marian - pokaż co potrafisz. Czekam na zmodyfikowaną wersję dcraw, która konwertuje RAW na JPG Twoim algorytmem. Arek z pewnością przeprowadzi testy. Pokażemy, że Polak potrafi. Jeżeli nie znasz C - polecam książki "ANSI C" Ritchiego i Kernigana oraz "Symfonia C++" Grębosza (ta ostatnia rządzi). Nauczenie się 50ciu dyrektyw C to przecież pestka w porównaniu z matematyką potrzebną do przeliczenia RAW na JPG. 80% masz zrobione w dcraw. W zasadzie wystarczy przyjrzeć się jak dcraw ładuje RAW do pamięci, z czego robi jpg oraz napisać jedną, może dwie proste funkcje ..... Wierzę, że autor dcraw'a chętnie Ci pomoże. Ja już więcej Ci nie wytłumaczę, bo obawiam się, że mam za małą wiedzę na Twoim poziomie rozumowania. Więc do czasu opublikowania pierwszych przykładów - z mojej strony EOT. Marian - Sro 05 Gru, 2007

Ja już robiłem zdjęcia, zanim utworzyłem wątek. Tyle że zrobiłem najpierw zdjęcie w rozmiarze x/2×y/2 a następnie w rozmiarze x×y. Nic w nich, czyli w tym co aparat zrobił, nie zmieniałem. Każde oglądałem na widoku 100%. I co zobaczyłem? To większe było mniej ostre w stosunku do mniejszego, a poza tym nie potrafiłem w nim znaleźć żadnych dodatkowych szczegółów, których by nie było w mniejszym. Dlatego podjąłem ten wątek. Założyłem wątek m. in. dlatego, że może ktoś ma zdjęcia pokazujące coś czego ja się nie doszukałem. Przecież nie upieram się że mam rację jeśli są takie zdjęcia. Porzucę swoją hipotezę jeśli istnieją zdjęcia, w których można się doszukać informacji, której nie zawiera mniejszy plik. Zdjęcie Arka nie ilustruje tego o czym piszę, bo powstało poprzez przeskalowanie, i to w dół (downsampling), większego pliku na mniejszy. Najlepiej byłoby wiedzieć, jakiej metody tworzenia trójkolorowego piksela używa producent aparatu do zapisu zdjęcia o rozmiarach x/2×y/2. Jeśli robi tak jak Arek, czyli z większego x×y, przez downsampling, robi mniejsze to korzystanie z opcji x/2×y/2 nie miałoby sensu. Wydaje mi się że jednak może robić to inaczej. Dlaczego? Dlatego że nie widzę aby mniejsze (x/2×y/2) obrazy z moich aparatów miały mniej informacji od tych x×y, a na pewno w 100% widoku są mniej ostre. Mam nadzieję, że teraz będzie już jasne, że ani nie utworzyłem, ani nie ciągnę tego wątku, ot tak sobie. Natomiast ani moje aktualne umiejętności, ani ilość wolnego czasu, nie pozwalają mi na tworzenie własnego programu konwersji plików RAW. |